さまざまなタスクをこなす万能型ジェネレーティブAIツール「ChatGPT」を担うOpenAI開発者向けのイベント「OpenAI DevDay」が11月7日に開催され、GPTや開発者向けインタフェース(API)の大きなアップデートが発表されました。本記事では、特に経営戦略の観点から統一的に、今回のアップデートにどういう意味があるのかを説明したいと思います。またアップデート内容の主要部分をそれぞれ、経営戦略を支える手段という観点で述べて行きます。

執筆:Preferred Robotics ソフトウェアエンジニア 礒部正幸

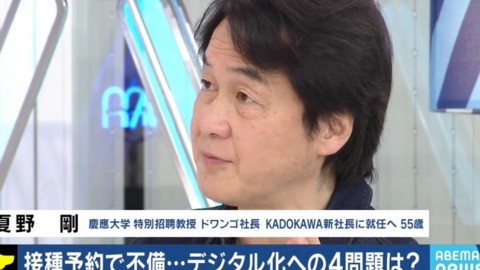

OpenAI DevDayでサム・アルトマンCEOが発表した内容とは

(出典:Open AI 報道発表)<目次>

- OpenAI DevDayで発表された内容

- OpenAIの独走を印象づける「GPT4 turbo」

- OpenAIの「プラットフォーム戦略×GPTs×GPTストア」

- 「ネットワーク透過性」とWeb

- 「ネットワーク透過性」とマルチモーダルAI

- PCやスマホの要らない未来を後押しする「AssistantsAPI」

- 既存の巨大企業GAFAMやNVIDIAの役割の変化とは

- UberEatsに垣間見る「マルチモーダルAIが独占する未来」

OpenAI DevDayで発表された内容

OpenAI DevDayの主な内容をピックアップすると以下の6つです。

- GPT4「turbo」発表: トークン数12万8000, 入力コスト3分の1, 予測コスト2分の1

- GPTs: ChatGPTのプラグインが作りやすくなった

- GPT Store: ChatGPTのプラグインをアプリストアで公開できるようになる

- APIがマルチモーダル対応: 画像や音声のAIを組み込みやすくなった

- Assistants API登場: 開発者に掛かる工数が格段に削減されることに

- その他: 著作権侵害保証や音声合成の品質向上など

いずれも大注目の大きなアップデートが目白押しですが、これでも一部です(すべての情報はOpenAIの公式ページに記載されています)。

DevDay(開発者向けのイベント)なので当然、いずれもChatGPTのAIを組み込んだアプリケーションを開発する開発者向けの機能強化となっています。

「開発者から要望の強い機能強化に取り組んできた」と語るサムアルトマンCEO

(出典:Open AI 報道発表)

OpenAIの独走を印象づける「GPT4 turbo」

DevDayにおいて最初に発表されたのはやはりGPT4の強化バージョンでした。「GPT4 turbo」と呼称されたその新バージョンはまさにOpenAIにとってフラグシップ(旗艦)ともいえる製品です。文脈をカバーする能力も、コストパフォーマンスも大きく改良されました。

具体的には、GPT4が3.2万トークンだったのが4倍の12.8万トークンになりました。トークン数の上限が増えると当然ながら賢くなります。GPTが「考えるときの前提となる情報」が増えるからです。たとえばGPTに与えるプロンプトの中に、自社ビジネスに関する情報を入れておくことで、より自社の都合に特化した動作が可能になりますから、トークン数は対話AIの能力を決める最重要スペックです。

正確に言うと、発話(途中で切れている対話を続けて完成させるという意味で、Completion:コンプリーション機能と呼ばれる)の機能実行の1回において、その直前の対話テキストとそれに対する応答としてGPTが発話するテキストの合計トークン数の上限のことを指しています。筆者が執筆したGPTの説明記事では、入力テキスト側のみをトークンと呼んでいましたが、GPTの商用プロダクトとしての仕様上は入力と出力両方の合計でカウントするようになっています。

その入力テキスト側のトークン数に対するコストがGPT4と比べて3分の1になり、出力テキスト(GPTの発話)側のトークン数に対するコストが2分の1となりました。さらに、実際にGPT4 turboを動作させると、動作スピードもGPT4と比べて格段に速くなりました。筆者個人の印象では、爆速といった感じです。

またさらに、(本記事で後述しますが)外部システムのAPIを呼ぶ際の柔軟性や、システム連携で非常によく使われるデータ形式であるJSONを扱う精度も大きく向上しました。

最近の情報にも詳しくなりました。2023年4月までの情報をキャッチアップできているとのことで、今後も随時最新の情報をキャッチアップしつづけるとのことです。

GPT4 turboの発表に合わせて、旧来モデルのGPT3.5 turboも料金ダウンが発表されました。

最近ではChatGPTの爆発的普及を受けて、フリーでオープンソースのLLM(大規模言語モデル: GPTもLLMの一種です)も次々と公開され、GPTの性能に近づけるどうか? という試みが非常に多方面で展開されています。しかし今回のGPT4 turboやそれに関連する機能強化・旧来モデルのコストダウンにより、やはり「本家」GPTが圧倒的に先攻しているのだという現実が改めて浮き彫りになったように筆者は感じています(SNS上でもそうした声を頻繁に目にしました)。

『HuggingFace』ではオープンソースのコミュニティによってLLMの改良や実験結果が共有され議論が交わされている

(Photo:T. Schneider / Shutterstock.com)

OpenAIの「プラットフォーム戦略×GPTs×GPTストア」

さて、旗艦サービスである「GPT4 turbo」以外にもたくさん機能強化が並んでいましたが、それらはどう捉えたらよいでしょうか?

まず「プラットフォーム戦略」が本記事1つ目の重要キーワードになります。

今回のDevDayに見られるように、アプリケーション開発者を手厚くサポートすることでアプリケーションを沢山作ってプラットフォームを普及してもらう、という方法はこれまでグローバルIT企業のやり方として幾度も繰り返されてきた「プラットフォーム戦略」の王道です。

スマホではアップルがiOSで、グーグルがAndroidで、クラウドではアマゾンがAWSで、デスクトップPCではマイクロソフトがWindowsで、そうした戦略を採ってきましたし、日本企業も特にゲーム業界において任天堂がファミコンをはじめ今はSwitchで、ソニーがプレイステーションで、プラットフォーム戦略を実行しています。

ここで注目したいのが今回の機能強化された「GPTs」です。開発者が自社のデータやサービスをつなぎ込んだChatGPT(のような対話アプリ)を簡単に作れるようになりました。GPTs利用の使い方のポイントはたとえば以下のようなことです

・自社データはOpenAIが提供するクラウドにアップロードしますが、ユーザーの許可なしにアップロードしたデータがChatGPT本体の学習データとして使われることはない

・自社サービスは(自社側にAPIが用意されていれば)ChatGPT側から対話の流れの中で自動的に自社APIを呼び出して実行させることで自社サービスとシステム連携ができる

・それらを開発者が効率良く行える開発ツール「GPT Builder」が提供されることになった

・通常、こうしたシステム間連携を行うには「APIの形式の合わせ込み」が必要になるが、それも「Code Interpreter」によってAIが自動的に仕様を理解して形式合わせることが可能に

もちろんこれまでも、そうしたChatGPTと外部サービスとのシステム連携は可能であり、ChatGPT Pluginsという形で本家ChatGPTからプラグインを選択する形でサードパーティのサービスをチャット内から呼び出すことはできていました。

今回のGPTsは、本家ChatGPTからプラグインとしてシステム連携するのではなく、最初から自社専用のChatGPTを作れるところが大きな違いです。そうして作った専用ChatGPTのユーザーインタフェースはもちろんChatGPTそっくりですから、ユーザーにとっては本家ChatGPTとそれらの各社独自ChatGPTを、アプリを切り替えるように使うことができます。

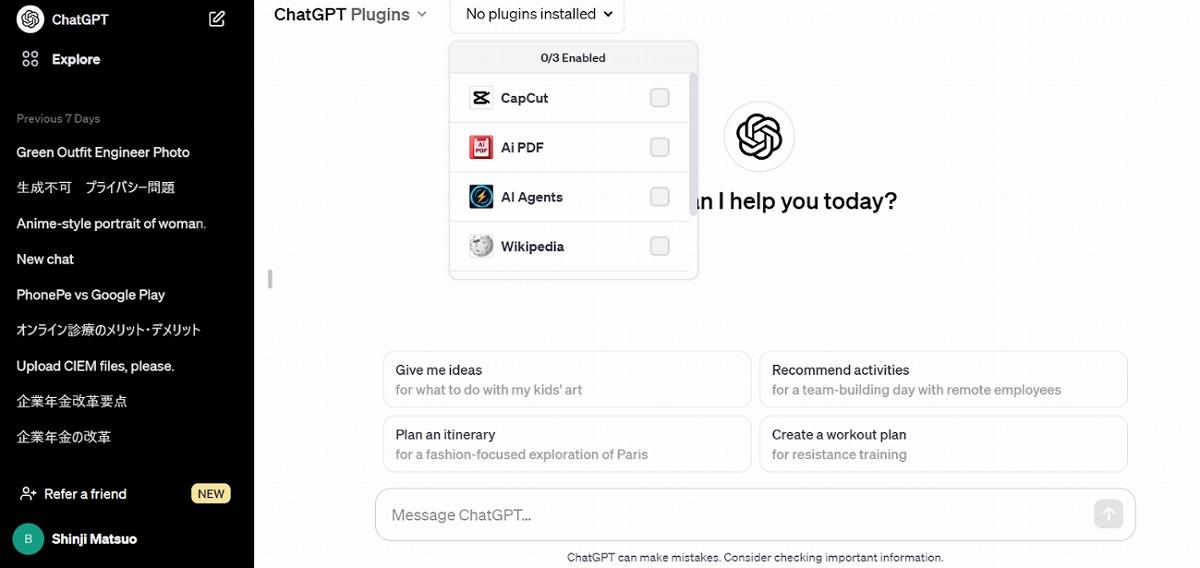

ChatGPT Pluginsの画面, 「本家ChatGPTから呼び出されるプラグイン」

(出典:ChatGPT Plugins)

アプリストア(iTunes AppStoreやGoogle Playのようなアプリマーケットプレイス)に相当する「GPTストア」もこの11月末を登場するとアナウンスされました。今すぐの登場でないのは、まだアプリの数がないからだと思われます。現在、各企業がGPTsの仕組みに乗っかって自社専用のChatGPTを開発しており、それが一定数集まったタイミング(11月末)に「GPTストア」がオープンするということでしょう。

「ネットワーク透過性」とWeb

さて、次に並ぶ機能強化として「マルチモーダルAI(画像や音声その他)の強化」や「AssistantsAPIの登場」があります。これらにはどんな意味があるのでしょうか?

それを説明するために、少し遠回りになってしまうかもしれませんが本記事2つ目の重要キーワードとして「ネットワーク透過性」という概念をふまえておきたいと思います。少し用語の説明にお付き合いください。

ITのネットワーク技術における専門用語として、「透過性」あるいは「透過的」という言葉があります。これは、そのネットワークの上に実現されている「サービス」を利用する際、ネットワークの技術的な詳細をユーザーが意識せずに済むという好ましい特長を指す言葉です。

たとえばWebブラウザを使えば、インターネットに接続しているのが無線LAN/Wifiなのか、有線ケーブルなのかといった接続形態を意識することなくWeb上の情報にアクセスできます。Web技術を用いることで具体的なインターネット接続の部分が「透明」になってあたかも「直接アクセス」できているかのように見える、というニュアンスが込められています。

つまり、Web技術はインターネットにネットワーク透過性をもたらす技術といえます。しかし、Webブラウザを使うためにはスマホやPCなどの機器(デバイス)が必要です。ユーザーがWebを使っているとき、今使っているのがどのスマホなのか、あるいは、どのPCを使っているのかを普通は「知って」います。なのでインターネットアクセス環境を、スマホやPCも含めて考えると、Web技術は「完全なネットワーク透過性」までは達していないのです。

経営戦略の観点でみると、この「ネットワーク透過性」は「市場の独占」と密接に関係しています。ネットワーク透過的な世界では、その「ネットワークの入口を確保した者が市場を独占」できます。たとえばかつてインターネットが普及していくときにブラウザ戦争やポータルサイト/検索エンジンのシェアをめぐって激しい競争があり、グーグルが勝った、というのが「ネットワーク透過的な世界における独占」の代表例です。

「ネットワーク透過性」とマルチモーダルAI

本節は、前節で述べた「ネットワーク透過性」という観点でみたときにWeb技術は、インターネットのネットワーク自体については透過的だが、接続しているデバイスも含めて考えると完全に透過的というわけでもない、という話の続きになります。

では、Webではなく対話AIでインターネットにアクセスする場合に「ネットワーク透過性」はどうでしょうか?

「今の」ChatGPTはWebブラウザやアプリ(公式のアプリがあります)から使う形ですので、ChatGPTのユーザーはWebを意識せざるを得ません。実際、今のところは「ChatGPTは便利なWebアプリケーションだ」というイメージが強いでしょう。

しかし対話AI自体は本来ブラウザがなくても動くはずのものです。音声インタフェースがあれば。また、画像インタフェースがあれば身振り手振りや指さしで(極端な話、手話で)システムを使うこともできます。よって、もしそうした(画像や音声のような)マルチモーダルなインターフェスが普及すればインターネットはWeb技術を使っているときよりも格段に「ネットワーク透過的」になります。

だからブラウザの上でChatGPTを動かしている今のうちから、OpenAIはマルチモーダル機能の強化を急いでいるわけです。

そうした先に、Web技術よりもネットワーク透過的な世界が実現していくと、グーグルを始めとする「Webの入口を抑えている既存の巨大企業」の地位が大きく揺るがされます。

OpenAIが実現しようとしているのは、まさにそういう世界でしょう。あのグーグルの地位が揺らぐなんてかつては想像しにくいことでした。しかし今はそれが確かに現実味を帯びてきています。

余談になりますが、ChatGPTというサービス名はもちろんOpenAI社のサムアルトマンCEOがつけたものだそうですが、これはとても機械っぽさを前面に押し出したネーミングだと思います。真偽は定かではないものの、これはわざと擬人化を避けることで社会インフラとしてのイメージをつけさせたのだという噂を筆者はSNSで何度か目にしました。

「透過性」という観点でみると、中間の存在をユーザーに意識させないためには擬人化などもってのほかです。ChatGPTは対話AIによってもたらされるサービスにおいて、インターネットはもちろんAIそれ自身までできるだけ「透過的」であるように意識してつけられたネーミングではないかと筆者は感じています(閑話休題)。

PCやスマホの要らない未来を後押しする「AssistantsAPI」

PCやスマホをマルチモーダルAIに置き換えるには、対話AIが画像や音声を扱う能力を向上させる以外にも必要なことがあります。

PCやスマホがないということは、ブラウザやアプリを動かすことができません。マイクやカメラから直接、AIが動かす必要があるのです。

これまで開発者は、チャットの履歴管理や独自の知識や情報をプロンプトに埋め込む仕組みなどをめいめいで作りこむ必要がありました。そのため、PCやスマホ、その先に用意する自社のクラウドサーバにおいてそのような処理を実行しなければならないのです。

しかし、今回登場したAssistantsAPIを使うと、そういう処理をすべてOpenAIのAPI機能にいわば「丸投げ」することができます。開発者は、GPTに与えるデータを用意したり、自社サービス側のAPIを説明するテキスト(プロンプト)を用意して、対話アプリケーションで実現してほしいことを自然言葉(プロンプト)で与えるだけで、自社システムと統合した対話システムを作れてしまいます。

本記事で既に述べた「GPTs」によってPC/スマホで使うチャットUIベースのシステムが簡単に作れ、本節の「AssistantsAPI」によってPC/スマホとは別のデバイスでの対話AIシステムも簡単に作れる、まさに死角なし、ですね。

実際に「GPTs」と「AssistantsAPI」は「開発者ができること」が似ています。

既にそうしたデバイスは登場しています。ちょうど先日、米国のヒューメイン(Humane)というベンチャー企業から発表された「Ai Pin」という製品はまさにそのものです(この企業はOpenAIとパートナーシップを結んでいるとのこと)。

マルチモーダルAIの常時利用を企図した胸バッヂ/ピン型デバイス「Ai Pin」

(出典:AI Pin 報道発表)

AssistantsAPIは、こうした新しい「インターネットの入口」を作る開発者の背中を押すような機能だと筆者は確信しました。

既存の巨大企業GAFAMやNVIDIAの役割の変化とは

インターネットの5大グローバル巨大企業の代名詞GAFAM(グーグル<Google>, Apple, Facebook(Meta), Amazon, Microsoft)、アップル<Apple>、メタ<Meta、旧Facebook>、アマゾン・ドット・コム<Amazon.com>、マイクロソフト<Microsoft>)は、インターネットの入口を押さえつづけることでその地位を維持していますが、OpenAIの目指すマルチモーダルAIが入口を押さえる未来に、これらの企業のポジションはどのようになるのでしょうか?

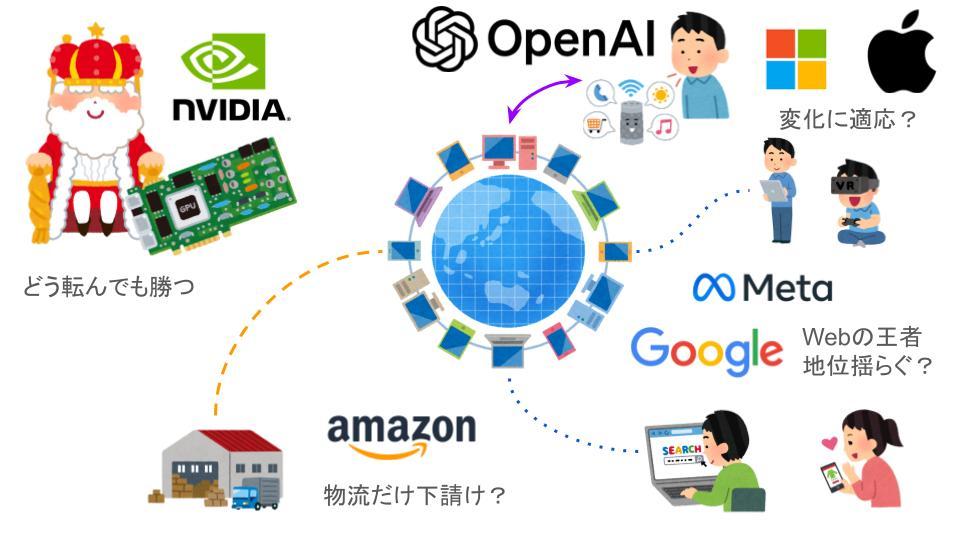

GAFAMやNVIDIAが置かれた立場についての筆者のイメージ

Google, Facebook(Meta)

GoogleやMetaは、検索やクラウド上の業務アプリ、SNSといった「Web上で完結するサービス」が主力事業ですので、インターネットの入口がWebではなくマルチモーダルなAIアシスタントになると最も影響を受ける立場です。Webを守ろうとするのでしょうか? マルチモーダルAIで真向勝負するのでしょうか? その両方にベットするのでしょうか? 今後どのように対抗していくのか非常に注目されます。

Apple, Microsoft

AppleやMicrosoftはインターネットを最大限利用した事業を主力としてはいますが、PCやスマホ、ゲーム機といったハードウェアによる収益源があります。Appleはよりハードウェア収益が大きいですし、MicrosoftはWebだけでなく多面的に展開しています。何よりもマイクロソフトはOpenAIに大きく投資しています。よってこれらの企業は、時代の進展に合わせて焦点をシフトしていく動きになるのではないでしょうか? 具体的な動向にはこちらも大注目です。

Amazon

筆者個人にとって「読めない」のがAmazonです。同社はWeb上で超大規模ショッピングポータルを抱えてはいますが、他の追随を許さない物流システムを持っています。インターネットの入口の主流がWebからマルチモーダルAIに代わっても、その物流システムは健在であり続けるでしょう。しかしAmazonの「Eコマースポータルとしてのブランド」が維持できるかどうかは今後の動向に左右されます。その点は非常に大きな注目ポイントです。

NVIDIA

安泰というかある意味一人勝ちなのがエヌビディア(NVIDIA)です。この各企業の構図においてAI向けの半導体においてトップシェアを握るNVIDIAは、まさに「ゴールドラッシュでツルハシを売る企業」そのものです。どう転んでも勝つ。

もちろん、インテルやAMDといった大企業をはじめ半導体(プロセッサ)ベンチャー企業たちも黙っていないでしょうから、未来永劫安泰というわけでもないかもしれません。今は盤石にみえるNVIDIAの地位を揺るがす存在は現れるのかどうか、という観点でウォッチしていきたいところです(筆者は新興のプロセッサベンチャーである「テンストレント(Tenstorrent)」に注目しています)。

UberEatsに垣間見る「マルチモーダルAIが独占する未来」

OpenAI DevDayで発表された主なアップデート内容について説明してきました。最後に本記事の締めくくりとして、このOpenAIが目指しているであろう未来が実現した状況について前節のGAFAM/NVIDIAの観点とは別に、ユーザからみた視点での考察もしてみたいと思います。

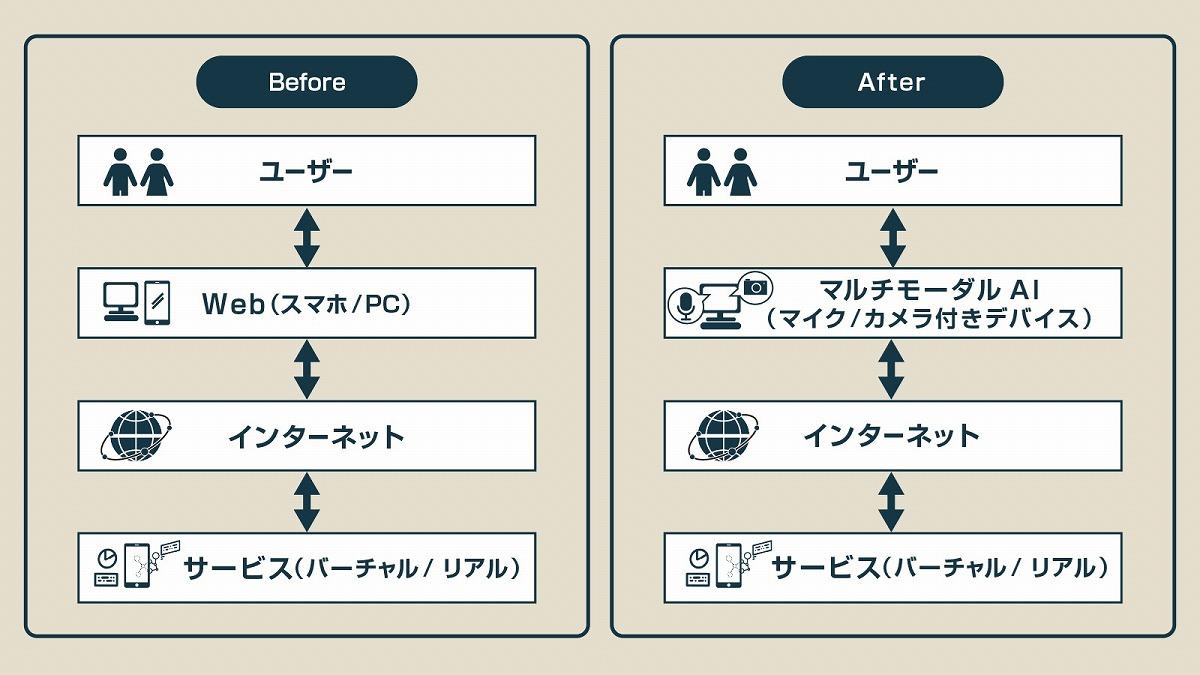

スマホやPCを開いてアプリやWebブラウザを立ち上げてインターネットにアクセスするのではなく、マイクやカメラが接続されたマルチモーダルAIによってインターネットにアクセスする世界を模式的に示すと下図のようになるでしょう。

「インターネットの向こうのサービス」はAIが「下請け」のように利用する

筆者が個人的に気になるのは、この未来の世界では、インターネット(は、ユーザーからは透過的で見えなくなりますが)の先にあるサービスが何であるかを、ユーザーがどのくらい意識するのだろうか?という点です。

UberEatsを例にとって考えてみたいと思います。なぜUberEatsかというと、UberEatsによってお店の検索サイトと注文機能(デリバリー含む)が1つのアプリに集約されたことは、まさにインターネットとその先のリアル世界のサービスにおける「ネットワーク透過性」が実現した世界の一端を示してるように思うからです。

Uber Eatsでデリバリーフードを注文する際、提供元(レストランなど外食サービス)の店名やブランドをユーザーはそれなりに認識するでしょう。こうしたアプリでは、(リピーター注文は別として)注文前に検索機能でフードやお店のジャンルから絞り込んでいって最終的に具体的なメニュー決定に至るという手順を踏むので、「お店のブランドは検討プロセスにおける後ろのほう」になります。何が食べたいか、が先です。

そうすると、長くやっていて評判が良いお店と、登録したばかりのお店が、同じジャンルのフードを提供した状況では、SEO(検索エンジン最適化)的な勝負となります。仮に新しいお店の方が品質やコスパが良かったとすると、最初のうちはそれまでの実績で検索エンジンのランキング上、新しいお店は優遇されないかもしれませんが、ひとたび注文が重なっていけば急上昇中のフードとしてランキング高く表示されるでしょう。

このような状況では、老舗であることのアドバンテージが相対的に低下します。「ブランドを維持するには中身でずっと勝っていかなければいけない」という当たり前の現実が、より徹底された世界ともいえます。

そして、この「検索」さえも「透過的」になるのがマルチモーダルAIが「インターネットの入口」を押さえる世界です。AIと音声対話でやりとりしてフードを決めるとき、AIへの信頼が厚すぎて、もしかしたらメニューの写真さえも表示されないかもしれません。

-480x270.png)